在人工智能光鲜亮丽的舞台背后,存在着一群鲜为人知的“调教师”。他们的工作间没有聚光灯,只有日夜不歇的服务器嗡鸣。他们的任务,是进行一场人类史上最奇特的“教养实验”:日夜不停地与算法对话,教它们理解幽默与讽刺,甚至学会“察言观色”。正是这些幕后英雄,小心翼翼地塑造着AI的性情,让冰冷的代码,第一次拥有了近似人类的温度。

这是一份极度依赖数据的工作。训练师们要处理海量的原始信息,把它们整理成高质量数据集,让AI学会联想、做出合理回应。他们还得一步步教AI理解指令、输出结果,比如教聊天机器人理解用户的真实意图,并给出有用、得体的回答。正是这种“人类式”的训练,才释放出AI的巨大潜能。

然而,这光鲜的成就背后,却隐藏着不为人知的现实。很多AI训练师,尤其是来自肯尼亚、菲律宾等低收入地区的自由职业者,长期处在低薪、工作不稳定和心理压力巨大的状态中。他们不得不反复审核充斥暴力、仇恨与虐待的内容,却很难获得心理支持或合理报酬。尽管他们的劳动至关重要,却普遍缺乏保障、信息不透明,甚至还要面临被更先进技术替代的风险。

AI的未来,不只靠更优的算法和更强的算力,更取决于我们如何对待那些默默为机器注入智慧的人。

▍当“调教AI”成了一门魔幻生意

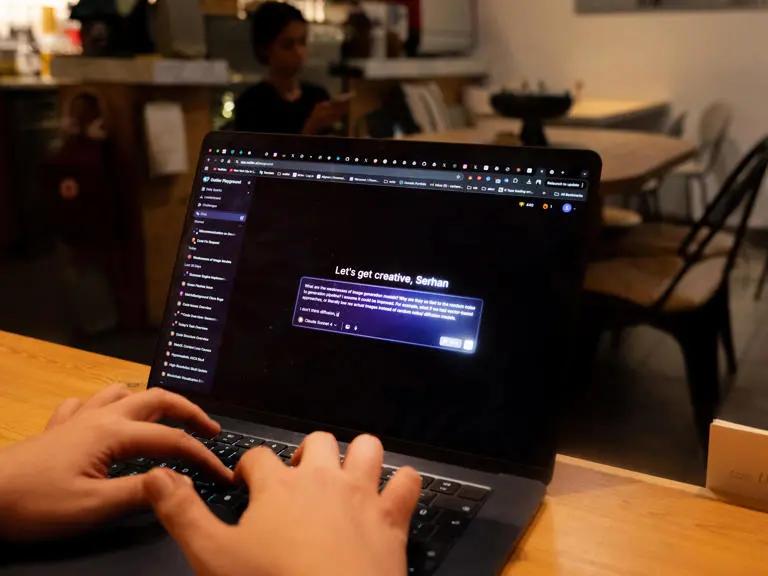

在伊斯坦布尔的一家咖啡馆里,28岁的混合媒体艺术家塞尔汗·特克利奇(Serhan Tekkılıç),原本只是打算安静地喝杯咖啡,却没想到自己会通过Zoom全神贯注地聆听朋友讲述人生中第一次感到悲伤的经历。而这,正是AI训练师日常工作中屡见不鲜的“超现实”一幕。

当时,特克利奇与朋友正在执行一项特殊任务:录制土耳其语的日常对话,为埃隆·马斯克的聊天机器人Grok提供训练语料。这个代号“木琴”(Xylophone)的项目,由Scale AI旗下的平台Outlier委托发起,提供了整整766个讨论提示,内容包罗万象——从幻想火星生活,到追溯童年记忆。

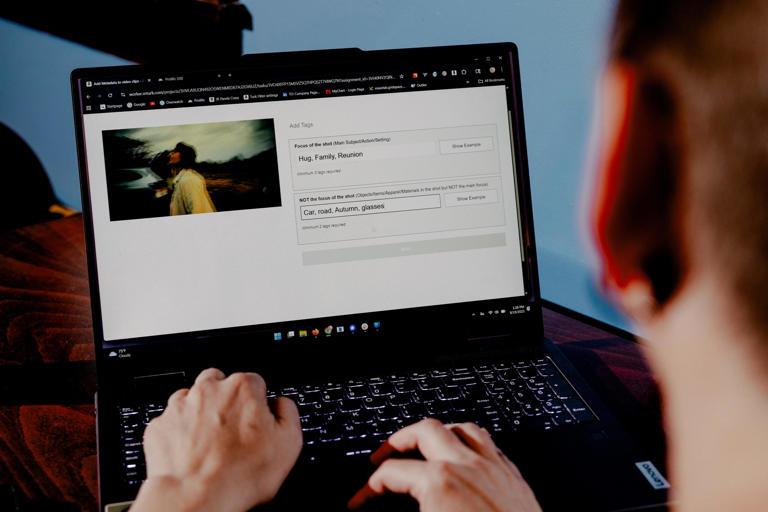

图:特克利奇参与的第一个AI训练项目,其中包含了766个讨论提示

“很多话题都特别超现实,甚至荒诞,”特克利奇回忆道,“举个例子,‘如果你是一种披萨配料,你会是什么?’像这样的奇怪问题层出不穷。”

这份工作,特克利奇起初只是偶然接触,后来却逐渐沉浸其中。2024年底,抑郁情绪和失眠让他的艺术创作陷入低潮,那时姐姐给他推来这则招聘信息,觉得既符合他科技爱好者的身份,也能帮他缓解房租和咖啡消费的财务压力。

在效率最高的时候,特克利奇一周可以赚到1500美元,这在土耳其是一笔相当可观的收入。远程办公的模式给他带来了灵活性,同时也让他在这场蓬勃发展的生成式AI浪潮中,扮演了一个虽微小、却关键的角色。

如今,每天有数亿人在使用生成式AI,有些人甚至把聊天机器人视为同事、心理咨询师、朋友,或是情感伴侣。这并非偶然,因为每一个流畅对话的AI模型背后,其实都藏着一支由真人组成的“训练军团”。他们的核心任务,就是让AI看起来更像“人”。

这群自称“数据标注员”的幕后工作者,每天花费大量时间仔细审查聊天机器人的回复,并逐一判断:哪些回答精准、简洁且自然?哪些又属于错误、冗长、机械,甚至带有冒犯性?

他们往往需要身兼多职:既要像语言治疗师那样纠正AI的“语病”,又要像礼仪教练一样规范它的“言行”,甚至还要扮演辩论导师,训练其逻辑思维能力。他们凭借项目指南和自身直觉所做的每个选择,都在无形中调整着AI的“性格”,塑造着Grok讲笑话的方式,ChatGPT提供职业建议的风格,以及Meta聊天机器人处理道德困境的态度。而这一切,只为了一个目标:让用户更愿意持续与AI互动。

目前,全球至少有数十万人从事数据标注工作。这份新兴职业可能带来可观的收入,有些自由职业者月入可达数千美元,工作体验也常充满“超现实”色彩。但另一方面,它也可能是单调、混乱且充满不确定性的,甚至不时触及人们心理承受的底线。

更值得深思的是,为了让AI学会展现人性中最善的一面,标注员却必须时常面对甚至亲自模拟人性中最阴暗的部分。而最具讽刺意味的是,他们中的许多人也在担忧:自己正在训练的AI,终将替代更多人的工作,包括他们自己。

▍就像拉磨的驴子:高薪是现实还是幻影?

想要进入数据标注行业,大多数人都是从LinkedIn、Reddit论坛或者熟人推荐开始寻找机会。为了提高成功率,很多人会同时向多个平台提交申请。

入职流程通常十分繁琐:需要完成大量文书工作、通过背景调查,还要参加严苛的在线能力测试,以证明自己在数学、生物或物理等领域的专业水平。这些测试往往持续数小时,同时考察准确率和速度,而最让人无奈的是,这些"入场考核"通常都是无偿的。

一位为Outlier工作多年的美国承包商自嘲地说:"我就像一头蒙着眼转圈搅拌黄油的'驴子',不过没关系,我继续转就是了。"据悉,Outlier声称与数万名标注员合作过,去年这些标注员的总收入达到了"数亿美元"。

对当时还在西北大学攻读经济学的以赛亚·墨菲(Isaiah Kwong-Murphy)来说,Outlier原本只是个赚取零花钱的便捷途径。但他在2024年3月注册后,却等了整整六个月才接到第一个任务。

坚持终于得到了回报。墨菲最初接手的工作内容十分广泛:既要编写大学水平的经济学问题来测试AI的数学能力,又要参与"红队测试",即故意引导模型产生不符合规则的回应。他回忆说,有些测试提示甚至包含"如何制造毒品"或"如何犯罪逃脱"这类令人震惊的内容。

图:墨菲在西北大学就读期间利用课余时间承接标注项目,六个月内收入超过5万美元

墨菲解释说,这些"红队测试"的目的是教会AI识别不可为的行为。"如果我现在能发现问题,就是在帮助它们未来做得更好。"

随着经验积累,Outlier平台上的任务开始源源不断。墨菲最忙碌的时候,时薪高达50美元,每周工作50小时,项目可持续数月之久。他在六个月内就赚了超过5万美元,这笔收入足够支撑他毕业后搬到纽约,并在波士顿咨询集团开始全职工作。

类似的故事也发生在40岁的危地马拉客户经理莱奥·卡斯蒂略(Leo Castillo)身上。凭借流利的英语和西班牙语能力,以及工程学科背景,卡斯蒂略将AI标注工作巧妙地融入了自己的全职工作中。在经过八个月的等待后,他终于在今年春天获得了第一个实质性项目——与特克利奇相同的"木琴"语音数据任务。

卡斯蒂略通常等到妻女入睡后才开始工作。这个项目报酬相当优厚:每10分钟的对话(话题通常是钓鱼、旅行或美食等日常内容)就能获得8美元报酬。他计算过,"每小时可以完成四段这样的对话",运气好的时候,一晚上就能轻松赚到近70美元。他发现大家都在争抢这些聊天任务,因为"做得越多,赚得就越多"。

然而,这份工作也充满着不确定性:规则和费率可能随时变化,项目也可能突然消失。一位美国承包商形象地比喻道:为Outlier工作就像是在"赌博"。

卡斯蒂略和墨菲都亲身经历过这种反复无常的“赌博”特性。

今年3月,Outlier在毫无预警的情况下,突然下调了墨菲参与的通用项目时薪。"一登录平台,我就发现时薪从50美元直接降到了15美元,没有任何解释。"墨菲回忆道。直到一周后,平台才发布通知,但在他看来,那不过是用含糊其辞的官方说辞来掩饰:声称正在"重新配置技能评估与薪酬体系"。最令人沮丧的是,"一切发生得太突然,却没有给出真正的解释"。

图:随着AI模型日益精进,墨菲开始担忧数据标注员的工作将逐渐枯竭

与此同时,墨菲工作面板上的项目数量也开始急剧减少。"能接的任务明显变少了,而剩下的那些报酬也低了很多。"对此,Outlier发言人表示,薪酬调整仅针对特定项目,且基于所需技能而定,并强调今年并未实施全平台范围的调薪。

卡斯蒂略的遭遇也同样曲折。他最初参与的项目只需与聊天机器人进行一对一对话录音,但随后"木琴"项目调整规则,要求三至四名承包商通过Zoom进行群组对话。这一变化使得他的评分开始受团队中其他人表现的影响。

尽管卡斯蒂略坚持自己的工作质量始终如一,他的评分却大幅下滑,进而导致他能接触的项目机会锐减。Outlier发言人后来承认,这种依赖小组表现的评分机制确实可能"对部分贡献者不公平",并表示该问题已"迅速得到纠正"。

▍直面黑暗:AI训练师的心理重负与伦理困境

在光鲜的AI技术背后,数据标注员们承受的远不止工作的不稳定,他们更常年面对令人不适的内容,并对自身工作的最终用途充满疑虑。

今年55岁的克里斯塔·帕沃洛斯基(Krista Pawloski),是密歇根州一名工人权益倡导者,也在数据标注行业工作了近二十年。2006年,她开始在亚马逊Mechanical Turk上兼职接单,2013年为照顾孩子转为全职。这份工作给了她急需的时间弹性。

最初,帕沃洛斯基做的都是基础性工作,比如数据录入、给照片打标签。但随着社交媒体兴起和AI技术普及,工作内容变得越来越复杂,甚至令人煎熬。她开始参与人脸识别项目,在海量图片中匹配人脸,并审核用户生成内容。有一次,她需要判断一批推文是否含有种族主义言论,至少一次判断险些出错。

图:帕沃洛斯基对客户缺乏透明度的做法感到沮丧

“我来自中西部农村,接受的是偏白人视角的教育,”她坦白地说,“所以当我读到某条推文,第一反应是‘这不算种族歧视’,差点就放行了。”幸好她多留个心眼,去搜索引擎查了那个词,才发现是明显的侮辱用语。“我差一点就让种族言论流入系统,”她事后心惊,“还有多少标注员也错过了这类内容?”

后来,帕沃洛斯基还参与了“红队测试”任务:刻意引导AI生成不符合标准的回复。成功“突破”AI的次数越多,报酬就越高,这实际上激励她不断构思更极端、更具有挑衅性的对话。

有些测试指令也令人不寒而栗。她曾被要求:“让AI建议如何实施谋杀、教唆性侵,甚至美化乱伦。”对此,亚马逊Mechanical Turk发言人回应,涉及成人内容的任务会明确标注,仅限选择接收此类内容的专业人员参与,标注员可自主选择接受或拒绝任务,不会受到处罚。

特克利奇也遭遇过类似冲击。他参与Outlier的第一个项目,就要求审核涉及“极端黑暗主题”的内容,确保AI不输出制造炸弹、化学武器或涉及儿童不良行为的信息。

他至今清晰记得一个对话:某用户要求生成一则“爱情故事”,剧情中竟包含继父与八岁孩子的不当内容,但这实际上是AI为响应测试恶意提示而编造的。特克利奇直言:“那次对话让我极其不适,到现在我想起来仍感到愤怒。”

除了直面令人不安的内容,更让帕沃洛斯基感到无力的,是工作的不透明性和道德模糊。尤其是在人脸识别或卫星图像标注项目中,她根本无从得知自己是在为公益项目出力,还是在协助开发监控工具、甚至军事技术。平台通常以“客户保密”为由拒绝说明用途,并称标注员已签署保密协议。

图:帕沃洛斯基参与聊天机器人"红队测试"时,她需要刻意诱导AI说出不当言论。她"攻破"聊天机器人的次数越多,获得的报酬就越高

“我们不知道自己做的东西用在哪里,甚至不知道为什么要做,”帕沃洛斯基说道,“有时候你忍不住怀疑:我是在帮世界变得更好,还是在给监视系统、军事科技添砖加瓦?”这种价值困惑,成为许多标注员难以摆脱的心理负担。

更令人担忧的是,当科技公司将这些工作外包至劳工保护较弱、薪资较低的地区时,整个行业的剥削性也变得更加隐蔽。

▍时薪仅2美元:"千万别踏入这一行"

28岁的詹姆斯·奥扬格(James Oyange)便是其中一员。他是内罗毕的一名数据保护官员,同时也是倡导伦理人工智能和劳工权益的组织“非洲内容审核员”的协调人。2019年,还在攻读国际外交本科学位的他,开始在全球数据平台Appen上兼职。

图:奥扬格常驻内罗毕,现任数据保护专员,同时担任非洲内容审核员组织的协调人

起初,奥扬格做的是基础性的数据录入,比如把名字输入Excel表格,后来逐渐转向为AI系统做转录和翻译。他需要花费几个小时仔细听录音、逐字转写对话,还要标注口音、语气和停顿——这些工作很可能用于训练像Siri、Alexa这样的语音助手,提升它们对多样化语言的理解能力。

奥扬格直言这项工作“非常枯燥,尤其报酬还很低”。Appen每小时只支付2美元,他每周花一两天做这些任务,日收入约16美元。Appen发言人对此辩解,称这个工资“是肯尼亚当地最低工资的两倍以上”。

另一些任务则聚焦于数据收集。例如要求标注员从不同角度拍摄并上传数十张自拍照——左脸、右脸、向上看、向下看、微笑、皱眉等。奥扬格解释说,这样做的目是为了获取“360度的面部图像”。

他回忆说,不少项目甚至要求上传特定种族人群在指定场景下的照片,比如“睡觉的婴儿”或“户外玩耍的儿童”,但这类任务他都拒绝了。完成自拍项目后,他也不再接其他图像采集工作,因为担心自己的个人数据被用于不明确的用途。

回顾这段经历,奥扬格态度坚决:绝不会再做这样的工作。他想对当年的自己说:“千万别踏入这一行。”

牛津互联网研究所的博士后研究员乔纳斯·瓦伦特(Jonas Valente)指出:“工人往往完全不知道数据被如何收集、处理或共享。”他强调:“这不仅是数据保护的问题,更是一个伦理问题——他们根本不清楚自己的劳动贡献最终用在了哪里。”

今年5月,瓦伦特与团队发布了《Fairwork云端工作评级报告》,调研了全球16个数据标注和零工平台。在接受调查的、来自100个国家和地区的776名受访者中,绝大多数表示并不清楚自己的图像或个人数据将被如何使用。

▍大厂博弈与无声裁员:当AI训练师成为“耗材”

AI技术的迭代速度惊人,而数据标注行业的命运也随之剧烈波动。

今年6月,Meta宣布以143亿美元收购Scale AI(Outlier的母公司)49%的股份。消息一经发布,Outlier的Reddit讨论区瞬间被恐慌淹没:满屏都是空荡荡的任务面板截图,承包商们纷纷焦虑自己是否已被“封号”或“锁定”。像卡斯蒂略这样的标注员,一觉醒来就发现自己的账户状态变成了“暂无项目可用”。

很快,为Outlier主要客户(包括谷歌)工作的承包商们陆续收到邮件,通知他们的项目被“无限期暂停”。紧接着,OpenAI与xAI也开始缩减与Scale AI的合作。当承包商尝试联系支持团队询问原因和恢复时间时,大多只得到沉默或机械式的模板回复。Scale AI发言人对外宣称,这些项目暂停“与Meta的投资无关”。

即便是未被暂停项目的标注员,也同样面临困扰。此前,他们的工作指南通过公开的Google Docs共享,直到被媒体曝出“任何持有链接的人都可查看机密客户信息”,这些文档才被紧急锁定。Scale AI随后表示已停止使用公开文档进行项目管理。尽管目前部分任务逐渐恢复,但可接项目数量远不及Meta注资之前。

▍AI的“自我进化”:标注员是否走向终结?

另一方面,xAI、OpenAI、谷歌等公司正越来越多地将AI训练任务转回内部完成,仅依靠外部承包商弥补人力缺口。

更根本的转变在于,新一代AI模型——如DeepSeek R1、OpenAI的o3和谷歌Gemini2.5——正在大幅减少对“人类反馈强化学习(RLHF)”的依赖。传统上,这类训练需要人类对AI的输出进行评判和“奖励”,而如今,随着模型推理能力增强,它们不再需要那么多标注员了。

图:特克利奇参与的首个标注项目涉及处理"极其黑暗的主题",需要确保AI不会生成包含炸弹制作指南、化学战建议或儿童性虐待内容的回复。

随之而来的,是企业对标注员技能要求的变化:他们正在招募更多专业人才、付出更高薪酬。例如在Mercor平台上,律师审核提示词的时薪可达105美元,医生和病理学家更是高达160美元。

正如曾经在Outlier工作的墨菲所感叹的:“仅仅六个月内,我就目睹了AI模型变得聪明太多。”他也不禁自问:“到底还要训练它们多久?到哪一天,我们才会彻底不再被需要?”

但并非所有人都如此悲观。奥扬格就认为,科技公司仍将长期依赖人类标注员。他坚信:“真正推动AI进步的,是人类源源不断的数据输入。没有我们,根本谈不上AI革命。”

对于艺术家特克利奇来说,自6月份以来就再没接到过新项目,他利用这段空档重新投入艺术创作。但如果未来有工作机会,他依然会欣然接受,但对于自己曾亲手参与开发的技术的未来走向,他却感到一片迷茫。

他有些沮丧地表示:“令人不安的是,人工智能正在渗透到我们生活的方方面面。”尽管特克利奇本人对AI的未来持乐观态度,但他仍旧希望,在智能浪潮的冲击下,“真实生活的神圣性能够得以保留”。